本研究グループの目指すところ

1.1 情報ネットワークの最近の流れ

インターネットは急速に産業社会や市民生活に浸透し、社会基盤として重要な役割を担うようになってきた。しかし、同時に管理の複雑さや脆弱さなどその限界も指摘されている。そこで、コンピュータによる情報処理とネットワークによる情報流通からなる情報基盤を根幹から見直し、現状の限界を克服する新しいネットワークアーキテクチャの確立の必要性が国の内外を問わず認識され、10〜20年後の実現を目指してこれまでにない革新的なネットワークアーキテクチャの構築を目指す取り組みが行われてきた。欧米諸国においても、従来のネットワーク技術とは異なる原理に基づくネットワークアーキテクチャの探索的研究は、米国NSF(FIA、GENIプロジェクト)、欧州EC(FP7プロジェクト)などを中心に活発化し、我が国においても(独)情報通信研究機構を中心に積極的な活動が行われてきた。

もちろん、インターネットが社会基盤になりつつある今、その仕組みを根本的に変更し、まったく新しいネットワーク基盤を導入することは現実的ではない。事実、上述の研究開発においても、ネットワーク資源(ノード、リンク)の仮想化、すなわち、物理ネットワーク基盤上にソフトウェア制御による仮想ネットワークをその通信要求に応じて柔軟に構成するSDN (Software Defined-Network) 技術が有効な手段として合意されつつある。しかし、その構成手法については相変わらず既存の設計手法、すなわち、情報流量やネットワーク構造を与条件として情報流の性能最適化を目的とする、いわゆる「全体最適化」を目的とするVNE (Virtual Network Embedding) が研究開発の主流となっている。さらに、ネットワークサービス機能の仮想化を対象とするNFVにおいては、ネットワーク資源のみならず、計算資源まで含めて構成する必要がある。NFVを全体最適化しようとする場合には、情報流量や構造的特性を与条件とした性能最適化を目的関数とすることが大前提になる。現時点においては、いわゆるオーケストレータがそれを解決することとされている。しかしながら、そのためには、「現時点」でのネットワーク上のあらゆる資源の利用状態を計測する必要があるが、対象システムの大規模複雑化によって正確な計測自体困難であることがそもそもの問題として挙げられる。さらに、設計変数が膨大になって、計算複雑度の観点から計算自体が困難になることなどから、最適化問題として扱うことは実質不可能である。現在すでにNFVオーケストレータの実装例もあるが、現場の開発者と議論しても、全体最適化は現実問題として困難なため、ごく一部しか実現できていないというのが実情である。

当然のごとく、現時点では特にSDNを中心にその分散化に関する研究も確かに行われている。SDNにおいてはコントローラがネットワーク資源の利用効率化を図るために集中計算を行うが、コントローラを分散化させることによって、計算処理の軽減を行い、スケーラビリティを確保するというものである。しかしながら、基本的には、全体最適化を図ることが目標になっており、問題の本質は変わらない。すなわち、前提としてあるのは、ネットワークの現時点での状態を完全に把握すれば、最適設計が可能になるというものであり、いわゆる要素還元論に基づくトップダウン的手法による最適化設計手法が相変わらず採られている。しかし、このような手法は、情報システム分野にとどまらず、広く工学分野におけるシステム設計手法における問題として、最近繰り返し指摘されてきているものである。すなわち、設計対象のシステムが大規模複雑化するにつれ、全体の状態把握が困難になること、設計変数が膨大になるため計算時間の爆発を招くこと、などから、既存の最適化問題による解法は用を成さなくなる。また、最適化問題による解導出が困難な場合、発見的手法による計算時間を軽減することが一般的に採られている手法であるが、その場合であっても、ある時点における最適解、あるいは準最適解が得られるのであって、対象システムの環境がすでに変化している場合には用をなさなくなる。

一方で、今後のネットワーク基盤技術として、以下の技術に関する研究開発も活発に進められている。

- IoT (Internet of Things)、M2M (Machine-to-Machine Communication) 通信のエンドノードはもはや人だけでなく、センサーデバイスやアクチュエータなどを接続し、実社会と仮想社会の融合によってより豊かな社会を目指す情報化基盤の構築が推進されている。

- CCN (Content Centric Networking)/ICN (Information Centric Networking) アドレス指定(ホスト指定+DNS)ではなく、コンテンツ名によるルーティングと発見による新しい通信パラダイムに沿ったネットワークアーキテクチャの確立が目指されている。

これらの技術は仮想化技術とともに独立のものではなく、その融合によってはじめて新しい情報社会基盤の構築が可能になるものである。例えば、仮想化技術によってさまざまなIoTサービスを融合させること、ICNによってIoTデバイスやサービスを発見すること、など可能性は無限にある。しかし、このような方向性は新たな技術課題も産み出す。例えば、

- インターネットの最近の流れを見ても、コンテンツ提供のために、GoogleやAKAMAIなどハイパージャイアントが登場しつつあり、インターネットトポロジーやトラヒック流の非構造化を生み出しつつある。この傾向は、仮想化技術によってさらに加速化されると考えられる。

- IoTやM2Mなどは実環境や仮想環境のセンシングからアナリティクス(分析や予測)を経てアクチュエータまでを扱う制御フィードバックを行うことが前提であり、その時間変動の粒度がますます小さくなること、また、多層化することなどが考えられる。

- CCN、SDN/NFVなどはネットワークサービスを実空間上ではなく、論理空間上で展開することを可能にする、すなわち、時空間ダイナミクスに対する適応性を可能にする技術であるが、それを適切に扱う理論基盤の確立はまだ今後の課題である。

などである。

これまでの古典的ネットワーク設計手法においては、対象としているネットワークのトラヒック量や構成情報が1月〜1年単位で取得できることが(暗黙の)仮定であり、最適化問題においてはそれらを静的情報として取り扱うこともじゅうぶん可能であった。また、ネットワーク設計問題において得られた解に基づいた、ネットワーク資源の増設はやはり同じような時間オーダで取り扱われることを前提としている。すなわち、1月あるいは1年を単位として、トラヒック情報を取得し、ネットワークの構成情報に基づいて、ネットワーク資源の増設箇所や増設量を定めることがネットワーク設計問題であった。一方、1分〜1時間単位の短期的なトラヒック変動への対応は制御問題として取り扱われ、例えば経路制御によって、故障も含めた対策がとられてきた。しかしながら、特にインターネットにおいては、最近、短期的変動がますます顕著になるとともに、長期的なトラヒック変動の予測は困難になっている。確かに年単位のトラヒック量の伸びは、政府やベンダーの計測結果に基づく予測もなされているが、それらはあくまでマスとしての予測であって、例えば、新しいサービスの急速な普及に伴う局所的な変動予測は極めて困難である。これまでネットワーク運用現場では、光ファイバ/無線通信の大容量化技術に支えられ、いわば物量作戦による対策がとられてきた。すなわち、トラヒック量の増大に対応するため、利用率の逼迫している箇所に順次リンクやノードの設備投資を行うという「場当たり的手法」が現実には採られてきた。インターネットにおける設計手法も数多く研究がなされてきているが、古典的ネットワーク設計手法において大前提となるトラヒック需要がそもそも予測困難であるところに根本的な問題がある。

特に、仮想化技術の発展に伴い、個別の仮想化ネットワークの設定がソフトウェア制御によってごく短時間に可能になりつつある今、設計の時間粒度と制御の時間粒度はほぼ同じ時間スケールになりつつある。すなわち、空間ダイナミクスと時間ダイナミクスを同時に扱うネットワーク設計制御が必要になっている。さらに、仮想化の対象として、ネットワーク資源(リンク容量やルータ処理能力)とともに、コンピューティング資源を考慮する必要があるが、コンピューティング資源の利用率の予測は極めて困難であり、これらの指標を既知であることを前提とした既存のネットワーク設計手法は現実的ではない。問題は、 (i) 仮想化技術に基づくネットワーク化情報処理基盤がこれまでの人工システムに見られない大規模かつ複雑なシステムであること、(ii) さまざまな通信要求に適応しなければならない開放系であり、その中でロバストな運用が必要とされること、(iii) 日々生み出される新しいサービスの中にはシステム設計時の想定を超えたものが数多くあり、情報流の急激な変化を引き起こすこと、に起因する。これらを前提としたシステム設計制御論を考える必要がある。すなわち、今後、大規模複雑システムとしての情報ネットワークにおいて、以下のような時空間ダイナミクスを扱う理論基盤、および、それに基づいた技術確立が必要である。

- 時間ダイナミクスへの対応 短期的には急激なトラヒック変動や故障などに対応し、また長期的にはトラヒック増大や新しいサービスの登場による変動に対応する必要がある。

- 空間ダイナミクスへの対応 モビリティなどの短期的変動だけでなく、情報数/端末数/ノード数/インターネット全体の構成に関する規模的成長による長期的変動に対応する必要がある。

このような試みを成功させるためには、これまでに発展してきた既成の情報ネットワーク学分野に閉じることなく、先端科学技術の融合、すなわち、先端的な科学の知見に基づいて情報ネットワークの技術開発を目指す、新たな研究領域としての情報ネットワークの理論的・技術的開拓が必須である。

1.2 将来のネットワークアーキテクチャの方向性

今後のネットワークアーキテクチャに必要とされる設計要件として,以下の3つを設定して研究に取り組んできた.

- 拡張性(scalability):インターネット利用人口の増加は言うまでもなく,センサー機器の増大,情報家電の普及など,インターネットに接続される情報機器端末の数は今後ますます増大する.また,それらの機器は当然,モバイル環境において利用されることが前提になる.その結果,ネットワーク資源の管理方法も当然変化せざるをえず,また,ルータ数やエンドホスト数,ユーザ数,さらにはセンサーなどの端末数の増大に対応可能としておく必要がある.

- 多様性 (diversity):ネットワーク技術はますます多様化しています.無線LANや第4世代技術などによる無線回線,FTTH技術などのアクセス回線,ギガビットイーサなどのLAN,光通信技術によるバックボーン回線など,さまざまな高速化技術が開発されつつある.その結果,過去たびたび提唱がなされてきたような単一のネットワークアーキテクチャによる統合ネットワークはもはや存在しえず,その結果,安定した通信回線をエンド間で提供するような通信形態の実現もあり得ないということになる.また,情報機器・デバイスの多様性からネットワークに流入するトラヒックの特性はますます多様化する.

- 移動性 (mobility):モバイル環境においては,利用者自身の移動を考慮しなければならない.そのためには,柔軟なネットワーク制御が必要になる.さらに,通信相手となる他の利用者にとっては,ネットワーク資源そのものの移動や生成・消滅までもが頻繁に発生することを意味することになる.また,P2Pなどのオーバレイネットワークのように情報資源提供者がサーバではなく,ユーザである場合,コンピュータをネットワークから容易に切り離すことも考えられる.さらにモバイル環境では,ルータ自体が移動する可能性がでてくる.

以上3つのキーワードを前提とすると,「すべてのユーザの通信要求を満たす」単一のネットワークアーキテクチャが存在しえないことは明らかである.それよりも,エンドホストの適応性(adaptability) 向上を根幹とし,ネットワークはそのような適応性をサポートするための機構を提供することを基本原理としていく必要がある.そのためには,エンドホストはネットワーク状態を自律的に実時間で知る必要があり,ネットワーク計測技術を根幹したエンドホストの制御が必須になる.また,トラヒック変動や故障だけでなく,ネットワーク資源の変動やエンド端末の移動などあらゆる環境変動に対処可能にするためには,ネットワークはエンドホストの適応性を前提とした自己組織型制御が重要になる.このような研究の方向性は,バックボーンのインフラストラクチャとなるフォトニックネットワークにおいても例外ではない.

インターネットはもともと分散指向といわれているが,実際にはそうではない.例えば,IP経路制御は分散志向であるとよく説明されているが,決してそうではない.現状のIP経路制御は,完全な分散制御ではなく,分散集中型あるいは協調型分散型と呼ぶのが正確である.例えばIP経路制御のひとつであるOSPFにおいては,すべてのルータ(エンティティ)が独自の判断によってパケットフォワーディングをするという意味では分散型であるが,すべてのルータが同一の情報を集めて,同一のネットワークトポロジーを持つことを前提に同じ動作をすることが前提である(集中分散型).また,他ルータも完全に同じ振舞いをすると期待して動作する(協調分散型).完全な分散制御でないことが,ネットワークの耐故障性の弱さにつながっている.このような問題を解決するためには,上述の多様性,拡張性,移動性を前提に,分散処理指向をさらに推し進め,しかし,それによって損なわれる資源利用の効率性については,エンドホストの現状のネットワークの状態に対する適応性によって補償していく必要がある.また,そもそも,効率性を追求することは,これまでの情報ネットワークの研究開発においては至上命題であったが,技術の進展によって性能はすぐに向上する.効率性よりも,耐故障性や適応性,スケーラビリティなどを向上できるネットワークアーキテクチャこそ今求められているものである.その結果,今後も開発されていくであろう多様な通信技術に対応することが可能になり,ユーザの多様な要求に対するサービスも提供できるようになる.

そのためには,個々のエンティティが自律分散的に動作し,全体では意図する制御が実現されるようなネットワーク,すなわち,自己組織型ネットワークを構築していく必要がある.また,今後もネットワークの階層構造は機能分割,機能分担という意味で重要な概念であり続けると考えられるが,その際にも,縦方向のエンティティである階層構造をより柔構造にしておく必要があろう.すなわち,従来のように階層を完全に分割するのでなく,上位層,下位層の状態に適応可能な制御構造を有するネットワークを構築することによって,自己創発型(エマージェント)ネットワークを構築していく必要がある.このような考え方は,複雑適応系の考え方そのものである.現状のインターネットも,それが人為的に作られたものにも関わらず,人が設計可能な範囲,制御範囲を超えつつある.複雑適応系としてインターネットを捉えることにより,大規模システム全体の振る舞いや設計手法,非線形システムとしての安定性,故障の連鎖反応の影響,ロバスト性等を解明し,最適性や最適解への収束速度を明らかにする等,その理論的役割に期待できるところは大きい.それらの過程を経て,人為的に設計・構築されたネットワークを結果として制御可能なものにしていく必要がある.

特に,エンドホストの自律性がますます要求されるようになると,それを前提として,ネットワーク全体の調和的な秩序が必要となる.これは適応複雑系においてまさしく議論されているところであり,それらの知見を活かすことの可能性が見えてくる.実際,これまでのインターネットにおいても,適応性を有する,また,頑強性や安定性を確保するシステム構築を行ってきた結果として,複雑適応系としての特徴が一部見られる.自己組織化制御はまさしくその特性を有するものであり,現状のインターネットでも採用されている考え方を推し進めると自己組織化ネットワーク,さらには,複雑適応系としてのネットワークに行き着く可能性が十分にある.その傍証が,P2Pやルータの接続関係において観測されているべき則である.その理由として,自己組織化,ダイナミックな成長,多くのエンティティが起こす相互作用などが原因として挙げられる.これらは今後のネットワークの目指すべき方向とまさに合致しており,結果としてべき則やスモールワールド性が見出される可能性も明らかにされつつある.これまで,べき則やスモールワールド性に関する科学的研究は,統計物理学,応用数学,社会学,経済学,生物学などで活発に行われており,これら異分野の成果を情報ネットワーク技術の進展に応用していくために,以下のように科学と技術の融合が重要である.

1.3 科学と技術の融合に基づく新しい情報ネットワーク科学の創出

われわれが推進しているネットワークアーキテクチャに関する研究は,以下の反省に基づいたものである.インターネットも含めてこれまでのネットワーク設計において,理論的な研究成果が技術の実現に活用された例は決して少なくない.特に従来は,待ち行列理論やトラヒック理論,ゲーム理論,最適化理論などの応用数学と密接に関連して研究開発が進められてきた.しかし,これまでの理論的研究は個別技術を対象としたものが多い.アーキテクチャは,本来,技術的手法と科学的手法の融合によって生まれるべきものである.しかし,現在,科学と技術の乖離があらゆるところで問題になっており,これは情報ネットワークの研究開発においても例外ではない.「科学的手法」は,すでに存在しているシステムに内在する普遍的な法則を探求するために,対象をモデル化し,数学的議論によって対象の性質を明らかにするものであり,一方,「技術」は新しい機能を実現する具体的な方法を案出し,モノを作り,利用するためのものである.本来,技術は,科学的手法から導いた性質をもとに新しい機能を実現するためにモデルを考え,実システムに適用することが重要であるが,従来はこの視点に欠けていた.すなわち,科学的手法によって得られた性質に基づき,それを技術として組み上げることが,アーキテクチャ構築の本質であるにも関わらず,従来はこのような循環がうまく機能していなかった.このような乖離が生じた理由は,例えば,情報ネットワーク分野においては,これまで用いられてきた理論が応用数学の借り物であり,情報ネットワークのために生まれた科学ではなかったことが大きい.また,以下のような現実的な問題もある.これまでの理論的手法は,現状および近未来の技術水準に基づくサービス品質の最適化を主眼としてきた.最適化の問題を容易に扱えるために,ネットワークシステム全体の最適化ではなく,ある階層やあるプロトコルを対象として最適化がなされてきた.情報ネットワークは階層化構造がとられているため,下位層は安定した構造を持ち,上位層からの要求を入力とすれば,このような仮定は十分に成立しうる.事実,インターネットにおいても,すでに,さまざまな小さな機能が追加されてきており,部分的な機能を最適化することは現実にも可能であった.また,特定の制御方式,プロトコルを対象とした最適化を行えば,階層すべてに渡ってこの作業を繰り返せば,最終的に全体のアーキテクチャの評価が可能になるという論理も成立しうる.しかし,もはやこのような仮定は成立しない.今後,適応的な情報ネットワークを実現するには,階層間の相互作用がよりダイナミックになるためである.

新しいネットワーク科学を創出することは容易ではないが,上述したべき則やスモールワールド性,自己組織化,自己成長,複雑適応系,創発性,非平衡系など,そのためのキーワードはすでにいくつか見えつつある.また,われわれが推進している生物の様態,特に自己組織化に学ぶネットワーク制御に関する研究開発の重要性は,以下の点にある.

- 生物の自己組織化に学ぶことによって,適応性,耐故障性に優れたネットワークシステムの実現可能性があること

- 生物システムにおいても,べき則やスモールワールド性,複雑適応系,創発性などの議論は盛んになされており,また,単に生物学だけでなく,物理学,応用数学,社会学などさまざまな分野における同様の取り組みによって,幅広い知識の融合が図れること

- 自然界の生物システムを変更することは容易ではないが,情報ネットワークは制御可能なシステムであり,巨大な実験場として他分野に供することが可能である.また,情報ネットワーク分野で得られた知見を他分野に示すことによって,互恵的な真の融合モデルを構築することも可能であること

これらの視点に基づき,新しいネットワークアーキテクチャの構築に向けた研究開発を進めてきたが,自己組織化制御の有用性とともに,その問題も明らかになりつつある.それについては次節において述べる.

1.4 管理可能な自己組織化情報ネットワークの制御・設計手法

最近取り組んでいる研究課題について述べる前に、自己組織化手法を情報ネットワークに適用した場合に、特に産業界から指摘される問題とそれに対する考察をまず述べる。

- 「結果がわからないのでは使えない」 自己組織化は,その基本理念として局所的なインタラクションによってシステム全体の創発を促すものであり,逆に言えば,それぞれのコンポーネントにおいては,創発の結果としての機能を,プログラム化されてはいない.しかし,そもそも,ミクロな設計からマクロなシステムを積み上げていく従来の要素還元論的設計手法,すなわち,サブシステムの積み上げによる全体システムの設計手法は,対象システムが大規模・複雑になっている現在,限界があり,そこに自己組織化手法の有用性がある.従来の設計手法においては,設計段階において慎重なパラメータ調整が必要であり,想定外の状況においてはその結果は予測できず,システム破綻を招くことが往々にしてある.一方,自己組織化制御においても,その設計段階において慎重にパラメータ調整をしておく必要があるが,想定外の状況においてもシステムが動作し続けることは明らかである.ただし,この点は,生物における環境適応性を含めて,これまでの経験的な知見に基づいたものであり,想定外の状況において,システムの外側からなんらかの制御を施す余地は残されている.

- 「保証できないネットワークはビジネスに使えない」 上述の点と同様,現在のシステムにおいて性能などなんらかの指標に対する保証性は,完全なものではなく,特に「高品質な性能」の保証は今のインターネットでは不可能であり,利用者だけでなく,システム提供者も半ば幻想を抱いているにすぎない.極論すれば,想定内の状況しか発生しない場合,すなわち,問題がない場合は,何をやっても(あるいは,何もやらなくても)システムは動作し続ける.問題があるとすれば,想定外の問題が発生した場合,従来のシステム設計手法では問題発生の状況を同定した上で想定外の状況が発生したため対応できなかったという言い訳が通用するが,自己組織化手法は環境適応型であるがゆえに,万が一,問題が発生した場合に,その問題の同定がうまくいくか必ずしも明らかでないという点であろう.

- 「管理できないネットワークは使えない」 ネットワーク管理が,現状のネットワーク状況を把握し,問題を把握してオペレータにレポートをし,また,オペレータがそれに適した資源操作を施すための情報を提供するものであるとすれば,自己組織化制御はそれらを自動化するものであると言える.ただし,自己組織化制御ではコンポーネントのインタラクションによってシステムの自動構成を目指すものであり,時間粒度が異なるものを指摘しているとも言える.一方で,比較的長時間の環境変化,例えば,トラヒック量増大やさらには新しいサービスの登場によるトラヒック需要の変動に対するネットワーク設計手法,すなわち,必要な箇所に対する回線容量増大やネットワークノードの設置(場合によっては削減)も重要な課題であり,それも複雑適応系として捉え,年単位の長期変動に対する成長耐性を有する手法も必要である.

- 「評価手法がない」 現状,自己組織化によって望む機能が発現するかどうかはシミュレーションによって確認する必要があり,この問題の指摘は正鵠を射ている.ただし,このようなシステムの基本原理に関する研究はさまざまな分野において取り組まれているところであり,分野融合によってさらなる発展が期待できる.我々も含めて新しい情報ネットワーク科学の創出に貢献していきたいと考えている.

以上の点を踏まえて,現在取り組んでいる研究においては,管理型自己組織化原理について研究を進めている.これは自己組織化制御のように個々のエンティティの創発性によって全体の創発に期待するだけでなく,自己組織化制御を基本としながら,現在の全体の状態を観測し,さらには将来を予測しながら,システム全体を望ましい方向に誘導するというものである.さらにそれを一歩進めて取り組んでいるのが生物の進化適応性 (Evolvability) に学ぶ情報ネットワーク設計・制御に関する取り組みである.ここでいう持続的成長可能性とは,

- 長期的(例えば,年単位)には進化しすぎて袋小路に入り込むことなく,すなわち,ある時点での最適性を追求するのではなく,将来に渡る予測困難な変化(規模的拡大,機能要求の変化)に対して適応できる成長可能性を有すること

- 一方,短期的(例えば,時分単位)には,環境変動に対してロバストであるだけでなく,現在の環境に対する制御可能性(Managed/Controlled Self-Organization)を有すること

1.5 生命システムの進化適応性に学ぶ情報ネットワークの制御・設計手法

上述のようにこれまで本研究グループでは生命システムの環境適応性に学ぶ情報ネットワークアーキテクチャに取り組んできた。それを一歩進めて取り組んでいるのが生物の進化適応性 (Evolution of Evolvability) に学ぶ情報ネットワーク設計・制御に関する取り組みである。ここでいう持続的成長可能性とは、

- 長期的(例えば、年単位)には進化しすぎて袋小路に入り込むことなく、すなわち、ある時点での最適性を追求するのではなく、将来に渡る予測困難な変化(規模的拡大、機能要求の変化)に対して適応できる成長可能性を有すること

- 一方、短期的(例えば、時分単位)には、環境変動に対してロバストであるだけでなく、現在の環境に対する制御可能性(Managed/Controlled Self-Organization)を有すること

を意味する。そのためには、短期的さらには長期的な将来の予測可能性 (Predictability)、変動するシステムの最適化 (Dynamic Optimization) についても同時に取り組んでいく必要がある。再び生物に学ぶことの有意性はそこにある。対応する生物学的用語は、ネットワークダイナミクス、Spontaneous(自発的な) Evolution、Plasticity、Controllabilityなどである。環境変動に対するロバスト性と進化適応性は、一見矛盾に見える。すなわち、ロバスト性を有するのであれば、環境変化に適応できることを意味し、進化適応性は不要である。一方、環境変動があった時にそれに適応できる進化適応性を有するのであれば、ロバスト性は不要である。もちろん、実際には、タイムスケールを考慮する必要がある。進化適応性は比較的長いタイムスケールでの、環境変化(システム規模拡大、利用形態の変化など)に対する遺伝的適応性を指し、一方、ロバスト性は短期の環境変動(トラヒック変動、故障)に対してシステムを適応させることを意味する。その結果、ロバスト性と進化適応性に必要な設計要件が見えてくる。すなわち、目指すべきは「進化適応性 (Evolution of Evolvability) のある持続的成長可能性」であり、短期的には、環境変動に対してロバストな環境適応性を有しながら、長期的には、進化しすぎて袋小路に入り込む(最適化)ことなく、将来に渡る予測困難な変化に対して適応できる進化適応性を有することが重要である。これは、ネットワーク用語で言いかえると、トラヒック変動、耐故障性、近接の機能を選ぶ環境適応性とともに、予測困難なシステム規模拡大、利用形態の変化、機能要求の変化と移動に対する進化適応性を有する必要があることを意味する。そのために、生物の縮退特性(Degeneracy; networked buffering)、表現型の可塑性(Plasticity)/エピジェネティクス、階層化とモジュラリティ (Hierarchy and modularity)などに注目しながら研究を進めているところである。

以上に述べた点を踏まえて、新世代ネットワークに関する研究開発を振り返ってみると、以下の点が問題であったと言える。当初は、クリーンスレート (clean slate) の考え方に基づいて、インターネットを根本から設計し直すという点が強調された。また、"Evolution vs. Revolution" の議論も盛んに行われた。しかしながら、今や社会インフラの一角をなすインターネットを一から再構築し直す (Revolution) ことは現実的にはありえず、そのため、新しいネットワークアーキテクチャへの移行を実現する (Evolution) 手段として、仮想化技術が注目された。仮想化技術が導入されれば、ある仮想化ネットワーク(スライス)上に新しいプロトコルやサービスを導入することも可能になる。ところが現状においては、SDNについてはデータセンターを中心にネットワーク早期導入の可能性に注目が集まり、また、NFVについてはハードウェアのコモディティ化やソフトウェアによる制御可能性に注目が集まっている。すなわち、仮想化技術が手段ではなく、目的になっているのが現状であり、それをもって仮想化技術をメタアーキテクチャと呼ぶこともある。しかしながら、個々のシステムをどう設計するか、また、これらを統合して扱う管理システムをどう設計するかについては、従来の全体最適化手法に基づくオーケストレータによって解決すると主張されるのみで、ネットワーク化情報処理基盤をどのように設計すればEvolutionalなシステムが構築できるかについてはほとんど議論されていないのが現状である。すなわち、仮想化技術をメタアーキテクチャと呼ぶことによって、新たなアーキテクチャを志向することなく思考停止に陥っていないかというのが、提案者らが持つ問題意識である。

また、新たな展開として、現在、第5世代移動体通信網(5G)に関する標準化、研究開発が進みつつある。当初は、エンド間遅延が1ms、帯域が10Gbpsなどの性能が言われ、まったく新しい無線通信方式、それに基づいたアーキテクチャがないと実現不可能な数値目標が示されていたが、最近議論は収束しつつあり、それぞれ「RAT内において」、「ピークデータレートでは」と注釈がつくようになっている。また、2020年の5Gサービスインもシンボリックなものになることが予想される。それよりも、いかにして既存ネットワークとの共存を図りながら新しいネットワークを導入し、移行していくかが重視されるようになっている。それが、仮想化技術に注目が集まる一因にもなっている。さらに5Gにおいては、従来のような無線通信の大容量化・高速化ではなく、ユースケースの議論をみても明らかなように、どのようなサービスを実現するか、実現可能か、がより重要になっている。

1.6 脳の情報処理機構に学ぶ情報処理基盤の制御・設計手法

最近、深層学習の成功によって、人工知能が3度目のブームを迎えている。その結果、ネットワーク分野においても深層学習を適用した研究に多く取り組まれるようになっている。しかしながら、深層学習を中心として機械学習に対して、多くの問題点がすでに指摘されている。

- 特徴量の設定が難しく、適用する問題に依存する。現状では、新たな問題に適用したこと自体に新規性が認められることも多いが、汎化能力の欠如が根本的な問題である。

- 正解データによる学習が必要であるが、多くのデータ(ビッグデータ)があれば過学習の問題がある。すなわち、問題依存だけではなく、環境依存の問題がある。特に環境が変化すれば、問題設定そのものを変更する必要もある。

- さらに、そもそもパラメータ調整が難しい。パラメータ調整によって学習性能が確かに向上する例も数多くあり、それが深層学習の応用研究として新規性が認められることにもつながっているが、性能向上が正解データの量や問題設定にも依存することが基本的な問題である。

- 正解検出率が、既存研究に対して相対的に見て向上があったとしても、絶対的な値が実用化には程遠いという研究例も数多くある。

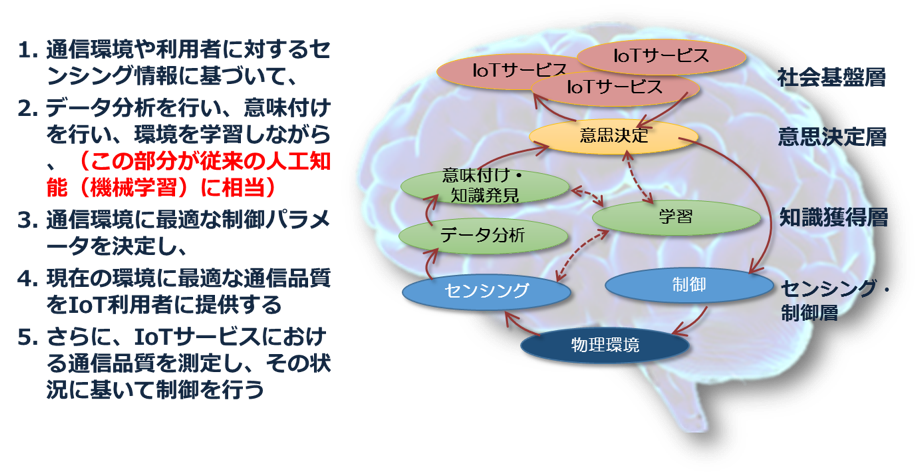

そもそも深層学習を含めたニューラルネットワークは1980年代の脳科学の知見に基づいたものであり、近年の情報技術(CPU高速化、分散化、メモリ大容量化)の発展によって可能になったものである。その結果、現在の「人工知能」は、研究者の創意工夫によって独自に「進化」してきたといっても過言ではない。より基本的な問題は、「最適性の追求」という従来の情報科学の方向性そのものが変わっていないという点である。例えば、IoTを例にとっても(図参照)、

- 応用の対象がさまざまであること

- 環境変化のあるなかで現状の状態を推定しなければならないこと

- 単に現状分析による最適解導出だけでなく制御を伴うこと

- 制御によって新たな環境に導かれること

最近特に、脳機能ネットワークに関する研究はfMRIなど測定装置の精密化によって飛躍的に進み、それを契機にネットワーク分析に関する研究が活発化しつつある。その結果、脳機能ネットワークは、スモールワールド性を示すこと、さらにフラクタル特性を有することが示されるようになっている。その結果、グラフ理論の観点からは、脳機能ネットワークはいわゆる「ハブノード」の故障に強いことなどが示されるようになっている。本研究グループにおいてもfMRIを用いた計測によって、脳機能ネットワークの詳細なデータを得てその分析を進めてきた。その結果、下層モジュールにおいて障害が生じても上層に波及しない性質を有すること、すなわち、外的環境に変化が生じても脳機能ネットワークの結合全体を再構築するのではなく、局所的な再構成によって対応できることなどを明らかにしてきている。現在、脳機能ネットワークのさらなる特徴抽出を行いながら、情報ネットワークへの適用を進めているところである。

さらに、最近は脳の情報処理機構に着目し、それをネットワーク化情報処理基盤に適用する試みを行っている。既に述べたように、これまでの古典的ネットワーク設計手法においては、対象としているネットワークのトラヒック量や構成情報が1月〜1年単位で取得できることが(暗黙の)仮定であり、最適化問題においてはそれらを静的情報として取り扱うこともじゅうぶん可能であった。一方、1分〜1時間単位の短期的なトラヒック変動への対応は制御問題として取り扱われ、例えば経路制御によって、故障も含めた対策がとられてきた。その結果、これまでネットワーク運用現場では、物量作戦による対策がとられてきた。すなわち、トラヒック量の増大に対応するため、利用率の逼迫している箇所に順次リンクやノードの設備投資を行うという「場当たり的手法」が現実には採られてきた。インターネットにおける設計手法も数多く研究がなされてきているが、古典的ネットワーク設計手法において大前提となるトラヒック需要がそもそも予測困難であるところに根本的な問題がある。特に、仮想化技術の発展に伴い、個別の仮想化ネットワークの設定がソフトウェア制御によってごく短時間に可能になりつつある今、設計の時間粒度と制御の時間粒度はほぼ同じ時間スケールになりつつある。すなわち、空間ダイナミクスと時間ダイナミクスを同時に扱うネットワーク設計制御が必要になっている。さらに、仮想化の対象として、ネットワーク資源(リンク容量やルータ処理能力)とともに、コンピューティング資源を考慮する必要があるが、コンピューティング資源の利用率の予測は極めて困難であり、これらの指標を既知であることを前提とした既存のネットワーク設計手法は現実的ではない。一方、脳の認知を含む情報処理機構はどうか。基本的に、脳の情報処理機構は

- 誤差を含んだ知覚情報、すなわち、センシング情報を抽象化して獲得する

- 抽象化されたセンシング情報に基づいて、時間とともに変化する確信度による意思決定・行動決定を行う

- その時々の状態に応じて制御にフィードバックする