本研究グループの目指すところ

1 情報ネットワーク研究の最近の流れ

インターネットは急速に産業社会や市民生活に浸透し、社会基盤として重要な役割を担うようになってきた。その結果、サスティナブルな通信基盤が求められるようになっている。すなわち、

- 既存の通信基盤を利用できること

- 常に新しい通信技術を収容できること

- 通信要求の急激な変化にも柔軟に対応できること

しかし、これらの技術の実現には、「現時点」でのネットワーク上のあらゆる資源の利用状態を計測する必要がある。しかし、対象システムの大規模複雑化によって正確な計測自体困難であることがそもそもの問題である。さらに、設計変数が膨大になって、計算複雑度の観点から計算自体が困難になることなどから、最適化問題として扱うことは実質不可能である。現在すでにオーケストレータの実装例もいくつかあるが、現場の開発者と議論しても、全体最適化は現実問題として困難なため、ごく一部しか実現できていないというのが実情である。

当然のごとく、対象とするシステムの分散化に関する研究も行われている。例えば、SDNにおいてはコントローラがネットワーク資源の利用効率化を図るために集中計算を行うが、コントローラを分散化させることによって計算処理の軽減を行い、スケーラビリティを確保するというものである。しかし、基本的には、全体最適化を図ることが目標になっており、問題の本質は変わらない。問題の前提としてあるのは、ネットワークの現時点での状態を完全に把握すれば最適設計が可能になるという思想そのものであり、いわゆる要素還元論に基づくトップダウン的手法による最適化設計手法が相変わらず採られていることである。しかし、このような手法は、情報システム分野にとどまらず、広く工学分野におけるシステム設計手法において、最近繰り返しその限界が指摘されている。すなわち、設計対象のシステムが大規模複雑化するにつれ、全体の状態把握が困難になること、設計変数が膨大になるため計算の爆発を招くこと、などから、既存の最適化問題による解法は用を成さなくなる。また、最適化問題による解導出が困難な場合、発見的手法による計算時間を軽減することが一般的に採られる手法であるが、発見的手法による場合であっても、ある時点における最適解に近い解を求めるという本質は変わらず、対象システムの環境がすでに変化している場合には用をなさなくなる。

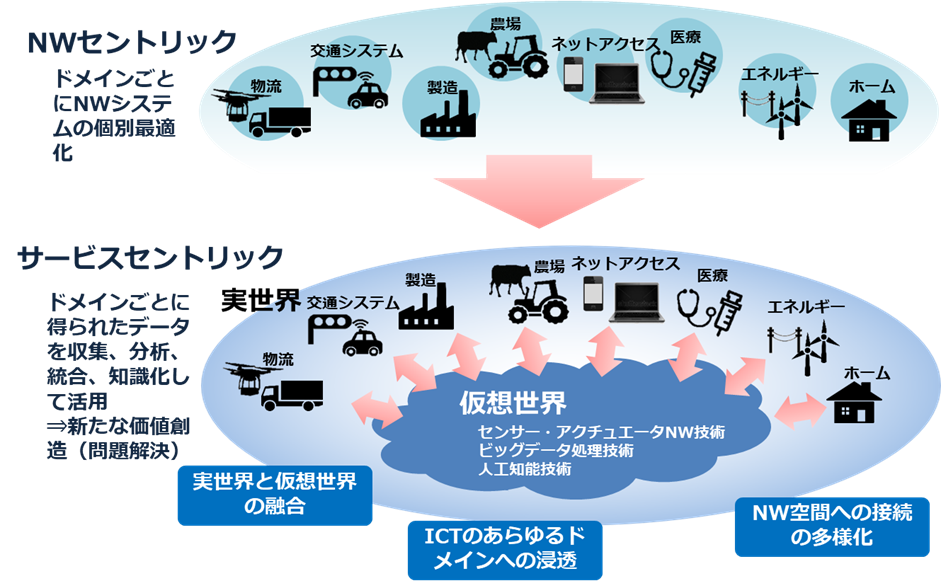

さらに、今後のネットワーク基盤として、CPS(Cyber-Physical System)/ IoT(Internet of Things)/ M2M(Machine-to-Machine Communication)もさかんに行われている。特に最近では、デジタルツインと呼ばれる実世界と仮想世界のインタラクションを明示的に考えたコンセプトも提示されている。すなわち、通信のエンドノードはもはや人だけでない。センサーデバイスやアクチュエータなどを接続し、実社会と仮想社会の融合によってより豊かな社会を目指す情報化基盤の構築が推進されている。これらの技術は仮想化技術とともに独立して存在するものではなく、その融合によってはじめて新しい情報社会基盤の構築が可能になるものである。例えば、仮想化技術によってさまざまなIoTサービスを融合させることなど可能性は無限にある。しかし、このような方向性は新たな技術課題を産み出す。例えば、

- インターネットの最近の流れを見ても、コンテンツ提供のために、GoogleやAKAMAIなどハイパージャイアントが登場し、インターネットトポロジーやトラヒック流の非構造化を生み出しつつある。この傾向は、仮想化技術によってさらに加速化されると考えられる。

- IoTやM2Mなどは実環境や仮想環境のセンシングからアナリティクス(分析や予測)を経てアクチュエータまでを扱う制御フィードバックを行うことが前提であり、その時間変動の粒度がますます小さくなること、また、多層化することなどが考えられる。

- ネットワーク仮想化技術はサービスを実空間上ではなく、論理空間上で展開することを可能にする、すなわち、時空間ダイナミクスに対する適応性を可能にする技術であるものの、それを適切に扱う理論基盤の確立はまだ今後の課題である。

これまでの古典的ネットワーク設計手法においては、対象としているネットワークのトラヒック量や構成情報が1月~1年単位で取得できることが(暗黙の)仮定であり、最適化問題においてはそれらを静的情報として取り扱うこともじゅうぶん可能であった。また、ネットワーク設計問題において得られた解に基づいた、ネットワーク資源の増設はやはり同じような時間オーダで取り扱われることを前提としている。すなわち、1月あるいは1年を単位として、トラヒック情報を取得し、ネットワークの構成情報に基づいて、ネットワーク資源の増設箇所や増設量を定めることがネットワーク設計問題であった。一方、1分~1時間単位の短期的なトラヒック変動への対応は制御問題として取り扱われ、例えば経路制御によって、故障も含めた対策がとられてきた。しかし、特にインターネットにおいては、最近、短期的変動がますます顕著になるとともに、長期的なトラヒック変動の予測は困難になっている。確かに年単位のトラヒック量の伸びは、政府やベンダーの計測結果に基づく予測もなされているが、それらはあくまでマスとしての予測であって、例えば、新しいサービスの急速な普及に伴う局所的な変動予測は極めて困難である。これまでネットワーク運用現場では、光ファイバ/無線通信の大容量化技術に支えられ、いわば物量作戦による対策がとられてきた。すなわち、トラヒック量の増大に対応するため、利用率の逼迫している箇所に順次リンクやノードの設備投資を行うという「場当たり的手法」が現実には採られてきた。インターネットにおける設計手法も数多く研究がなされてきているが、古典的ネットワーク設計手法において大前提となるトラヒック需要がそもそも予測困難であるところに根本的な問題がある。

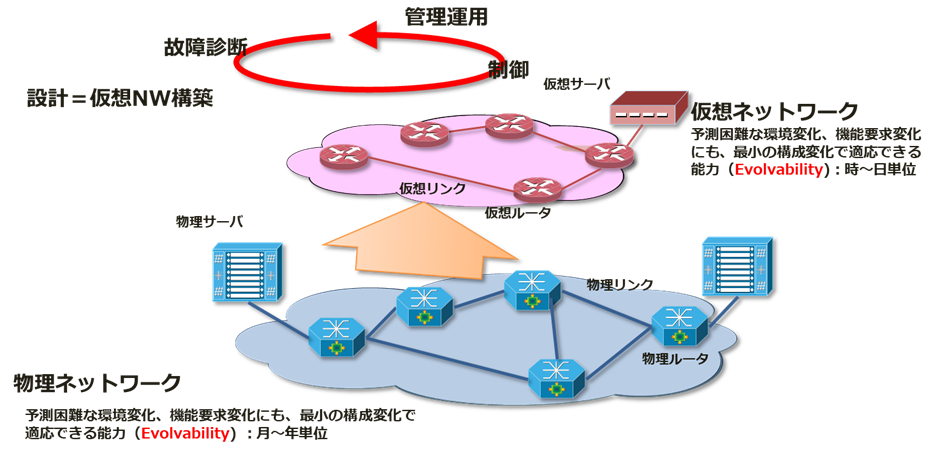

特に、仮想化技術の発展に伴い、個別の仮想化ネットワークの設定がソフトウェア制御によってごく短時間に可能になりつつある今、設計の時間粒度と制御の時間粒度はほぼ同じ時間スケールになりつつある。すなわち、空間ダイナミクスと時間ダイナミクスを同時に扱うネットワーク設計制御が必要になっている。さらに、仮想化の対象として、ネットワーク資源(リンク容量やルータ処理能力)とともに、コンピューティング資源を考慮する必要があるが、コンピューティング資源の利用率の予測は極めて困難であり、これらの指標を既知であることを前提とした既存のネットワーク設計手法は現実的ではない。問題は、 (i) 仮想化技術に基づくネットワーク化情報処理基盤がこれまでの人工システムに見られない大規模かつ複雑なシステムであること、(ii) さまざまな通信要求に適応しなければならない開放系であり、その中でロバストな運用が必要とされること、(iii) 日々生み出される新しいサービスの中にはシステム設計時の想定を超えたものが数多くあり、情報流の急激な変化を引き起こすこと、に起因する。これらを前提としたシステム設計制御論を考える必要がある。すなわち、今後、大規模複雑システムとしての情報ネットワークにおいて、以下のような時空間ダイナミクスを扱う理論基盤、および、それに基づいた技術確立が必要である。

- 時間ダイナミクスへの対応

- 短期的には急激なトラヒック変動や故障などに対応し、また長期的にはトラヒック増大や新しいサービスの登場による変動に対応する必要がある。

- 空間ダイナミクスへの対応

- モビリティなどの短期的変動だけでなく、情報数/端末数/ノード数/インターネット全体の構成に関する規模的成長による長期的変動に対応する必要がある。

2 将来のネットワークアーキテクチャの方向性

今後のネットワークアーキテクチャに必要とされる設計要件として、これまで以下の3つを設定して研究に取り組んできた。

- 拡張性(scalability):インターネット利用人口の増加は言うまでもなく、センサー機器の増大、情報家電の普及など、インターネットに接続される情報機器端末の数は今後ますます増大する。また、それらの機器は当然、モバイル環境において利用されることが前提になる。その結果、ネットワーク資源の管理方法も当然変化せざるをえず、また、ルータ数やエンドホスト数、ユーザ数、さらにはセンサーなどのデバイス数の増大に対応可能としておく必要がある。

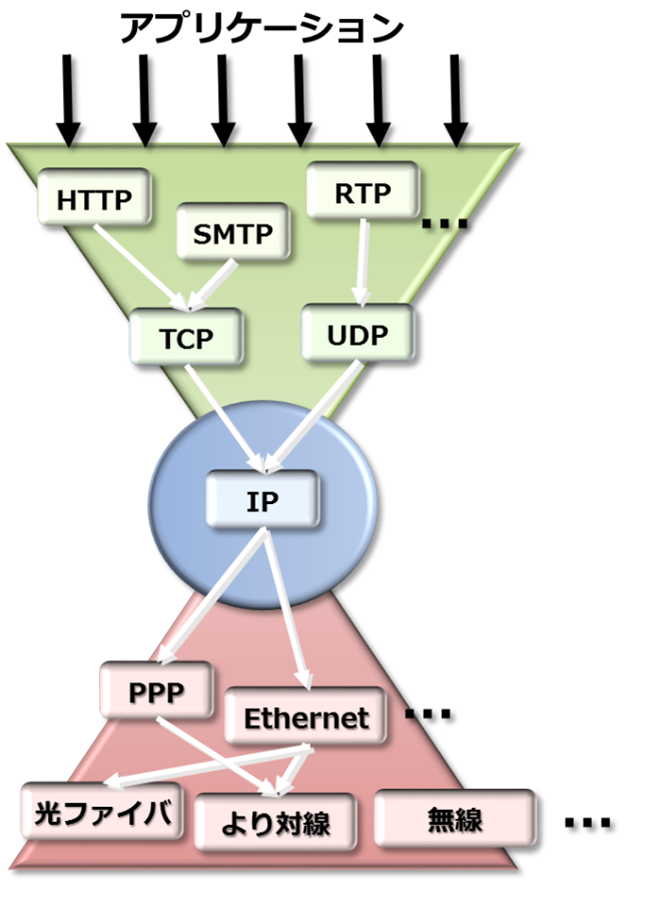

- 多様性(diversity):ネットワーク技術はますます多様化している。無線LANや第4世代移動体無線通信技術などによる無線回線、FTTH技術などのアクセス回線、ギガビットイーサなどのLAN、光通信技術によるバックボーン回線など、さまざまな高速化技術が開発されつつある。さらに、SDNやNFVなどの仮想化技術の他、第5世代移動体無線通信技術も研究開発が開始されている。その結果、過去たびたび提唱がなされてきたような単一のネットワークアーキテクチャによる統合ネットワークはもはや存在しえず、その結果、安定した通信回線をエンド間で提供するような通信形態の実現もあり得ないということになる。また、情報機器・デバイスの多様性からネットワークに流入するトラヒックの特性はますます多様化する。

- 移動性(mobility):モバイル環境においては、利用者自身の移動を考慮しなければならない。そのためには、柔軟なネットワーク制御が必要になる。さらに、通信相手となる他の利用者にとっては、ネットワーク資源そのものの移動や生成・消滅までもが頻繁に発生することを意味することになる。また、オーバレイネットワークのように情報資源提供者がサーバではなく、ユーザである場合、コンピュータをネットワークから容易に切り離すことも考えられる。さらにモバイル環境では、ルータ自体が移動する可能性がでてくる。

インターネットはもともと分散指向といわれているが、実際にはそうではない。例えば、IP経路制御は分散志向であるとよく説明されているが、決してそうではない。現状のIP経路制御は、完全な分散制御ではなく、分散集中型あるいは協調型分散型と呼ぶのが正確である。例えばIP経路制御のひとつであるOSPFにおいては、すべてのルータ(エンティティ)が独自の判断によってパケットフォワーディングをするという意味では分散型であるが、すべてのルータが同一の情報を集めて、同一のネットワークトポロジーを持つことを前提に同じ動作をすることが前提である(集中分散型)。また、他ルータも完全に同じ振舞いをすると期待して動作する(協調分散型)。完全な分散制御でないことが、ネットワークの耐故障性の弱さにつながっている。このような問題を解決するためには、上述の多様性、拡張性、移動性を前提に、分散処理指向をさらに推し進め、しかし、それによって損なわれる資源利用の効率性については、エンドホストの現状のネットワークの状態に対する適応性によって補償していく必要がある。また、そもそも、効率性を追求することは、これまでの情報ネットワークの研究開発においては至上命題であったが、技術の進展によって性能はすぐに向上する。効率性よりも、耐故障性や適応性、スケーラビリティなどを向上できるネットワークアーキテクチャこそ今求められているものである。その結果、今後も開発されていくであろう多様な通信技術に対応することが可能になり、ユーザの多様な要求に対するサービスも提供できるようになる。

そのためには、個々のエンティティが自律分散的に動作し、全体では意図する制御が実現されるようなネットワーク、すなわち、自己組織型ネットワークを構築していく必要がある。また、今後もネットワークの階層構造は機能分割、機能分担という意味で重要な概念であり続けると考えられるが、その際にも、縦方向のエンティティである階層構造をより柔構造にしておく必要があろう。すなわち、従来のように階層を完全に分割するのでなく、上位層、下位層の状態に適応可能な制御構造を有するネットワークを構築することによって、自己創発型(エマージェント)ネットワークを構築していく必要がある。このような考え方は、複雑適応系の考え方そのものである。現状のインターネットも、それが人為的に作られたものにも関わらず、人が設計可能な範囲、制御範囲を超えつつある。複雑適応系としてインターネットを捉えることにより、大規模システム全体の振る舞いや設計手法、非線形システムとしての安定性、故障の連鎖反応の影響、ロバスト性等を解明し、最適性や最適解への収束速度を明らかにする等、その理論的役割に期待できるところは大きい。それらの過程を経て、人為的に設計・構築されたネットワークを結果として制御可能なものにしていく必要がある。

われわれが推進しているネットワークアーキテクチャに関する研究は、以下の反省に基づいたものである。インターネットも含めてこれまでのネットワーク設計において、理論的な研究成果が技術の実現に活用された例は決して少なくない。特に従来は、待ち行列理論やトラヒック理論、ゲーム理論、最適化理論などの応用数学と密接に関連して研究開発が進められてきた。しかし、これまでの理論的研究は個別技術を対象としたものが多い。アーキテクチャは、本来、技術的手法と科学的手法の融合によって生まれるべきものである。しかし、現在、科学と技術の乖離があらゆるところで問題になっており、これは情報ネットワークの研究開発においても例外ではない。「科学的手法」は、すでに存在しているシステムに内在する普遍的な法則を探求するために、対象をモデル化し、数学的議論によって対象の性質を明らかにするものであり、一方、「技術」は新しい機能を実現する具体的な方法を案出し、モノを作り、利用するためのものである。本来、技術は、科学的手法から導いた性質をもとに新しい機能を実現するためにモデルを考え、実システムに適用することが重要であるが、従来はこの視点に欠けていた。すなわち、科学的手法によって得られた性質に基づき、それを技術として組み上げることが、アーキテクチャ構築の本質であるにも関わらず、従来はこのような循環がうまく機能していなかった。このような乖離が生じた理由は、例えば、情報ネットワーク分野においては、これまで用いられてきた理論が応用数学の借り物であり、情報ネットワークのために生まれた科学ではなかったことが大きい。また、以下のような現実的な問題もある。これまでの理論的手法は、現状および近未来の技術水準に基づくサービス品質の最適化を主眼としてきた。最適化の問題を容易に扱えるために、ネットワークシステム全体の最適化ではなく、ある階層やあるプロトコルを対象として最適化がなされてきた。情報ネットワークは階層化構造がとられているため、下位層は安定した構造を持ち、上位層からの要求を入力とすれば、このような仮定は十分に成立しうる。事実、インターネットにおいても、すでに、さまざまな小さな機能が追加されてきており、部分的な機能を最適化することは現実にも可能であった。また、特定の制御方式、プロトコルを対象とした最適化を行えば、階層すべてに渡ってこの作業を繰り返せば、最終的に全体のアーキテクチャの評価が可能になるという論理も成立しうる。しかし、もはやこのような仮定は成立しない。今後、適応的な情報ネットワークを実現するには、階層間の相互作用がよりダイナミックになるためである。

新しいネットワーク科学を創出することは容易ではないが、上述したべき則やスモールワールド性、自己組織化、自己成長、複雑適応系、創発性、非平衡系など、そのためのキーワードはすでにいくつか見えつつある。また、われわれが推進している生物の様態、特に自己組織化に学ぶネットワーク制御に関する研究開発の重要性は、以下の点にある。

- 生物の自己組織化に学ぶことによって、適応性、耐故障性に優れたネットワークシステムの実現可能性があること。

- 生物システムにおいても、べき則やスモールワールド性、複雑適応系、創発性などの議論は盛んになされており、また、単に生物学だけでなく、物理学、応用数学、社会学などさまざまな分野における同様の取り組みによって、幅広い知識の融合が図れること

- 自然界の生物システムを変更することは容易ではないが、情報ネットワークは制御可能なシステムであり、巨大な実験場として他分野に供することが可能である。また、情報ネットワーク分野で得られた知見を他分野に示すことによって、互恵的な真の融合モデルを構築することも可能であること

3 生命システムの進化適応性に学ぶ情報ネットワークの制御・設計手法

上述のようにこれまで本研究グループでは生命システムの環境適応性に学ぶ情報ネットワークアーキテクチャに取り組んできた。それを一歩進めて取り組んでいるのが生物の進化適応性(Evolution of Evolvability)に学ぶ情報ネットワーク設計・制御に関する取り組みである。ここでいう持続的成長可能性とは、

- 長期的(例えば、年単位)には進化しすぎて袋小路に入り込むことなく、すなわち、ある時点での最適性を追求するのではなく、将来に渡る予測困難な変化(規模的拡大、機能要求の変化)に対して適応できる成長可能性を有すること

- 一方、短期的(例えば、時分単位)には、環境変動に対してロバストであるだけでなく、現在の環境に対する制御可能性(Managed / Controlled Self-Organization)を有すること

持続発展可能なネットワークの追求自体は、決して新しい課題ではない。これまでも繰り返し言われてきたことであるが、なぜそれが実現されなかったか。ネットワークが非平衡系であり、その設計手法のための基礎理論がなかったことが理由である。本研究ではそれを生物の統合進化説(次項参照)に求める。もちろん、生物システムにおいては、環境変化によって種が絶滅することも現実にはある。本研究では、将来のさまざまな環境変化を想定し、トラヒック予測手法も併用して最適解を求める。ただし、ここでの最適解は「進化適応するネットワーク設計に基づいた将来に渡って発展可能性を有する解」であり、将来に渡る投資コスト最小解の追求を意味する。これは、これまでのネットワーク分野における「現時点での最適性追求」とまったく異なる発想に基づくものである。

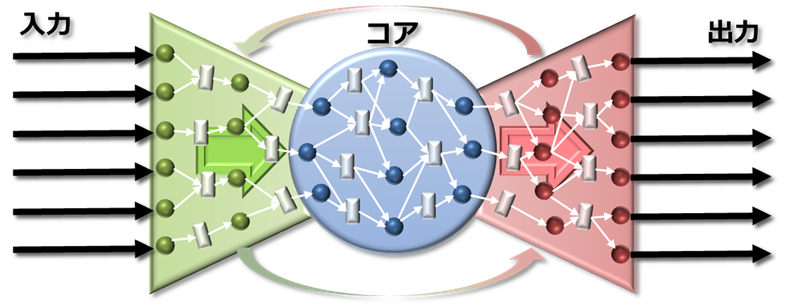

我々は、生物の進化適応性(Evolution of Evolvability)に着目している。すなわち、生物は環境変動に適応して進化するが、その進化自体への適応能力も有しており(Evolution of Evolvability)、世代を経て進化を繰り返す中で環境に対する適応能力が加速する。その根幹を成すのは、遺伝型の多様性と表現型の可塑性(Plasticity)である。これを制御可能とするものとして、生物の縮退特性(Degeneracy; networked buffering)、階層化とモジュラリティ(Bow-Tie構造、Hierarchy and modularity)などに注目しながら研究を進めている。

以上に述べた点を踏まえると、仮想化技術における問題は、仮想化技術の導入そのものを目的にしていることである。個々のシステムをどう設計するか、また、これらを統合して扱う管理システムをどう設計するかについては、従来の全体最適化手法に基づくオーケストレータによって解決すると主張されるのみで、ネットワーク化情報処理基盤をどのように設計すればEvolutionalなシステムが構築できるかについてはほとんど議論されていない。仮想化技術をメタアーキテクチャと呼ぶことによって、新たなアーキテクチャを志向することなく思考停止に陥っていないかというのが、われわれが持つ問題意識である。実際、現状におけるスライス再構成問題の定式化では、相変わらず仮想化の対象である物理資源を制約条件とし、トラヒックが変化せず安定していることを明示的あるいは暗黙的に仮定し、性能最適化を目的としたものがほとんどである。本研究では、ネットワーク及びスライスを閉鎖系として扱うそのような仮定自体がもはや成立しえないことを前提に、仮想化技術を支える物理ネットワークの設計手法を確立する必要がある。

また、第5世代移動体通信網(5G)に関する標準化、研究開発が2020年の実現に向けて進みつつある。当初は、エンド間遅延が1ms、帯域が10Gbpsなどの性能が言われ、まったく新しい無線通信方式、それに基づいたアーキテクチャがないと実現不可能な数値目標が示されていたが、最近議論は収束しつつあり、それぞれ「RAT内において」、「ピークデータレートでは」と注釈がつくようになっている。また、2020年の5Gサービスインもシンボリックなものになることが予想される。ネットワークの進化という観点から考えると、いかにして既存ネットワークとの共存を図りながら新しいネットワークを導入し、移行していくかを重視すべきである。それが、仮想化技術に注目が集まる一因にもなっている。さらに5Gにおいては、従来のような無線通信の大容量化・高速化ではなく、ユースケースの議論をみても明らかなように、どのようなサービスを実現するか、実現可能か、がより重要になっている。しかし、どのようなサービスが実現されるかはもちろん明らかでない。ユースケースの議論では、今のサービスの延長線上でどのようなものが実現されるかが中心になっているが、もちろん、現在予測し得ないサービスが実現されることが重要であり、それこそが技術の新たな発展を支えるものである。そのためには、常に発展し続けるネットワーク技術や情報処理技術を取り入れながら進化発展可能なネットワーク化情報処理基盤が必要である。それがわれわれの目的であり、そのヒントが脳や生物システムにある。

生物システムに関する研究においても、個々のサブシステムが自己組織化によって短期的な環境変動に適応する能力、すなわち、環境適応性を有するだけでなく、長期的な環境変動に対する適応する能力、すなわち、進化適応性も有することはすでに指摘されている。また、生物システム全体として急激な進化適応を行うことは決してないことも知られている。これらの事実に基づけば、ネットワーク化情報処理基盤においても、個々のサブシステムにおいて環境適応能力のみならず進化適応能力を備えることによって、全体としても進化適応能力を有するようなシステム設計論の展開は可能になると考えている。すなわち、われわれのアプローチは現在および将来にわたるさまざまな環境変動に対する適応性(環境適応性および進化適応性)を実現することを狙ったものであり、従来の要素還元論に基づくシステム最適化とはまったく異なる、逆の発想に基づいたものである。すなわち、個々のサブシステムにおける短期的および長期的環境適応能力、およびサブシステム間の接続に関する統一的な設計論を構築し、それに基づいてロバストな全体システムを設計するためのアーキテクチャを構築していくべきである。

現在、特に、仮想化技術に基づくネットワーク化情報処理基盤の構築のために、生物システムのさまざまな階層や脳において見られる、時間的空間的に柔軟な情報処理機構としてのBow-Tie構造に着目している。ただし、Bow-Tie構造においては、コアを自己組織的に構成することが環境適応性を有するための必須条件となるが、特にコアの詳細な定量的分析についてはじゅうぶんに明らかになっていないのが現状である。また、生物システムがどのようにして環境適応性と同時に進化適応性を獲得しているかについては、Degeneracyをコア構造に組み込んでいく。すなわち、われわれが目標とするネットワーク化情報処理基盤においては、トラヒック変動や機器故障などに対する適応性を環境適応性と捉え、また、より長期の変動に対する適応性を進化適応性と捉えることによって解決する。これまでは、例えば、ある時点において物理ネットワーク資源 / コンピューティング資源の不足によって性能劣化が生じた場合、該当箇所に資源投資を行う必要があった。しかし、一部の箇所に過度に資源を集中投資することは、将来のトラヒック変動によって無駄な投資につながる可能性がじゅうぶんにある。仮想化技術によってこのような問題が解決されると一般に言われているが、決してそうではない。仮想化資源を頻繁に移動させることは時間的コストを伴うこと、そもそも物理資源が存在しない制約条件を考慮する必要があること、さらに物理資源の投下の場所や時期を定める手法がないこと、などの問題を解決する必要がある。これらの問題に対する解決策がわれわれの目指す進化適応性である。

生物システムにおけるBow-Tie構造は情報処理ユニットであり、階層的に構成されることによって全体システムをなす。Bow-Tie構造は、以下の基本特性を有するものとして説明される。

- コアは密な接続構造を持つ。

- コアネットワークは課せられた制約の中で、処理を行う。

- 入出力ネットワークの制約は比較的緩やかで、さまざまな入出力に対応できる。

- 入出力を伴う機能モジュールとみることによって、コンピューティング処理やソフトウェアモジュール、あるいは、ハードウェアモジュールへの適用が可能である。

- コアの内部構造を詳細化することによって、物理的ネットワークや仮想ネットワークを表現できるだけでなく、コア内部の処理ネットワークとして、例えば、NFVにおけるサービスチェイニングへの適用も簡単に行える。

- Bow-Tie構造をビルディングブロックとして階層化を成すと考えれば、仮想化基盤におけるさまざまな階層構成への適用も容易に記述できる。

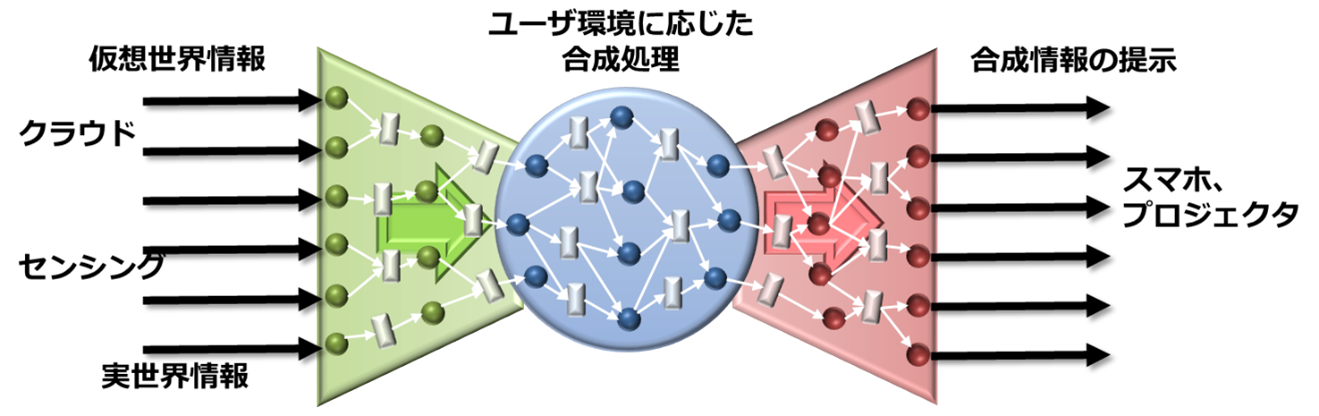

具体的サービス例として、例えば、Mixed Reality(複合現実感:MR)が考えられる。MRは、AR(Augmented Reality)を拡張し、双方向のリアルタイム情報処理を行うものである。AR自体いくつかの捉え方があるが、基本的には、目的に応じて、センシングによって実世界情報(カメラによる視覚情報やGPSによる位置情報等)を獲得し、実世界情報に対して仮想世界の情報を重ねあわせるものである。さらに、Googleストリートビューのように仮想世界に実世界の情報を重畳する場合も含めて複合現実(MR:Mixed Reality))と呼ぶ場合もあるが、基本的には、センシング情報に基づいて実世界を認識し、それに仮想世界情報をできるだけ速くユーザに提示することが必要になる。図は、Bow-Tie構造によって、ARの処理の流れを示したものである。

例えば、5Gにおいて実現が検討されているMobile Edge Computing(MEC)においてもARは代表的なユースケースのひとつになっている(Yun Chao Hu, Milan Patel, Dario Sabella, Nurit Sprecher and Valerie Young, “Mobile Edge Computing: A key technology towards 5G,” ETSI GS MEC-IEG 004 V1.1.1, September 2015. 図3)。この図からも明らかなように、MECにおいてはキャッシュデータを用いた処理がネットワークエッジで実現されることにより、応答時間の大幅な短縮が期待される。しかしながら、ユーザ端末と処理サーバのRTTの短縮による効果は当然期待されるものの、新たな価値を産むものではない。

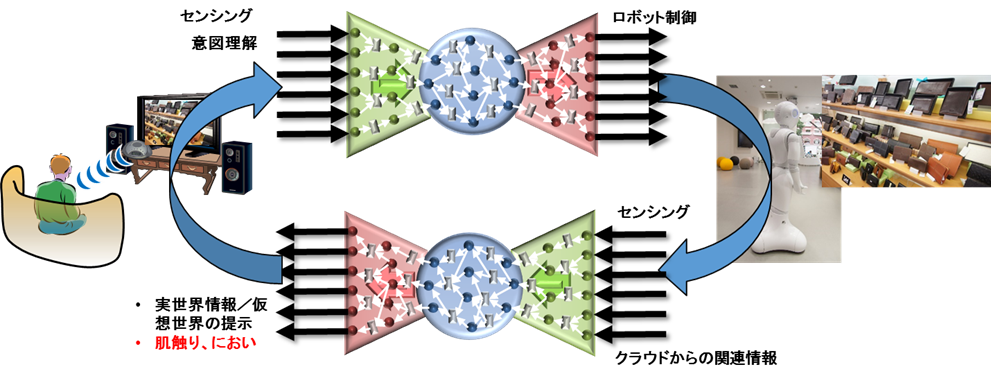

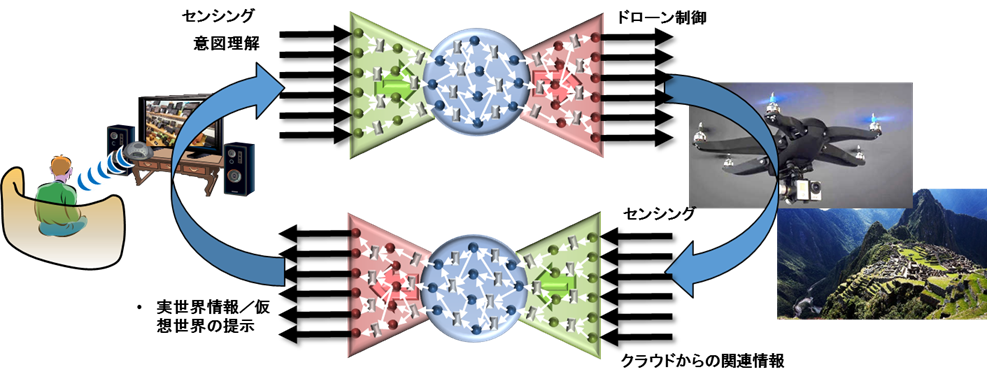

一方、われわれの考えるMRは、以下のようなサービスである。利用者が、遠隔地においてもできる限り現実感を伴うことによる実体験が可能なサービスである。例えば、地方に在住の人や外出が困難な老人が商品を実際に手にとって選びながら買い物をする、現実感を伴った旅行を楽しむ、など実世界における代行サービスが利用シーンである。ロボットによるアバターの実現という捉え方も可能であり、それをもってここではMRと呼んでいる。重要な点は、行動が制限されている利用者であっても現実感を伴った体験ができるようになる点である。MRによって、双方向におけるリアルタイム処理を行いながらも、利用者の状況に応じて適応的な処理を行うこと、遠隔地の状況が変化すると適応的に処理の変更を行うこと、などの技術課題を解決できる。ただし、サービスとして完成させるには、カメラや装着メガネによる視線トラッキングなどのセンシングによる利用者の意図理解、意図理解に基づくロボットの自動遠隔操作、ロボットに装着されたカメラなどによる遠隔地の状況理解、それらを利用者にリアルタイムにフィードバックした場合の遠隔地の状態の提示方法などを解決しなければならない。また、匂いや手触りなどの情報提示なども当然必要になる。これらについては、他分野の技術の発展を待つ必要がある。

4 脳の情報処理機構に学ぶネットワーク化プラットフォームの制御・設計手法

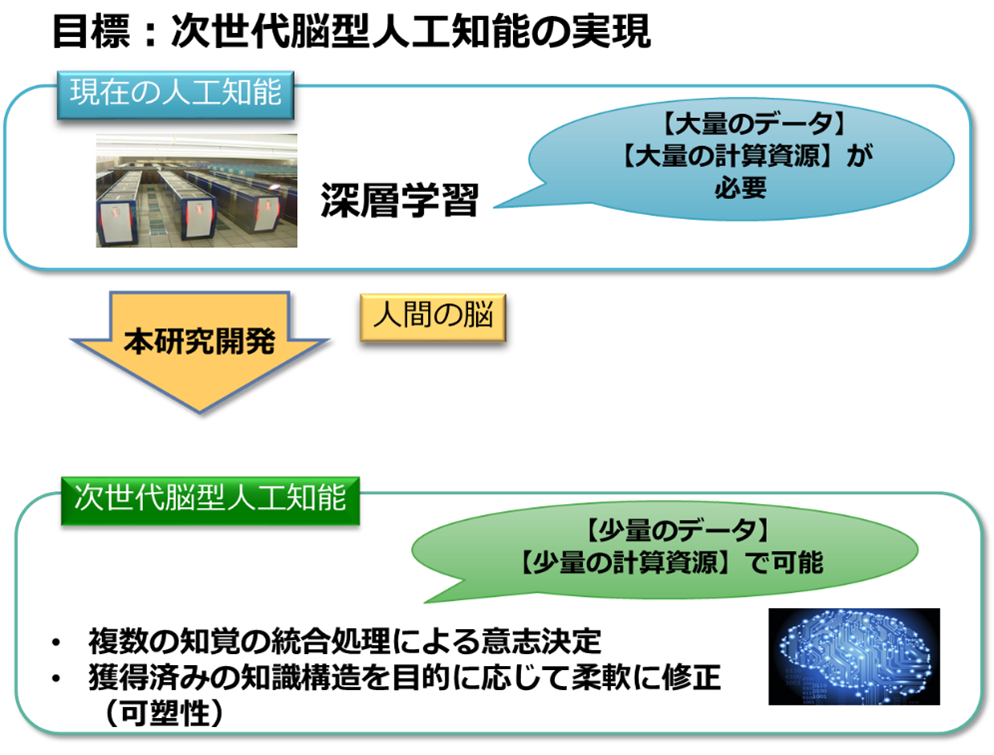

最近、深層学習の成功によって、人工知能が3度目のブームを迎えた。その結果、ネットワーク分野においても深層学習を適用した研究に多く取り組まれるようになっている。しかしながら、深層学習を中心として機械学習に対して、多くの問題点がすでに指摘されている。

- 特徴量の設定が難しく、適用する問題に依存する。現状では、新たな問題に適用したこと自体に新規性が認められることも多いが、汎化能力の欠如が根本的な問題である。

- 正解データによる学習が必要であるが、多くのデータ(ビッグデータ)があれば過学習の問題がある。すなわち、問題依存だけではなく、環境依存の問題がある。特に環境が変化すれば、問題設定そのものを変更する必要もある。

- さらに、そもそもパラメータ調整が難しい。パラメータ調整によって学習性能が確かに向上する例も数多くあり、それが深層学習の応用研究として新規性が認められることにもつながっているが、性能向上が正解データの量や問題設定にも依存することが基本的な問題である。

- 正解検出率が、既存研究に対して相対的に見て向上があったとしても、絶対的な値が実用化には程遠いという研究例も数多くある。

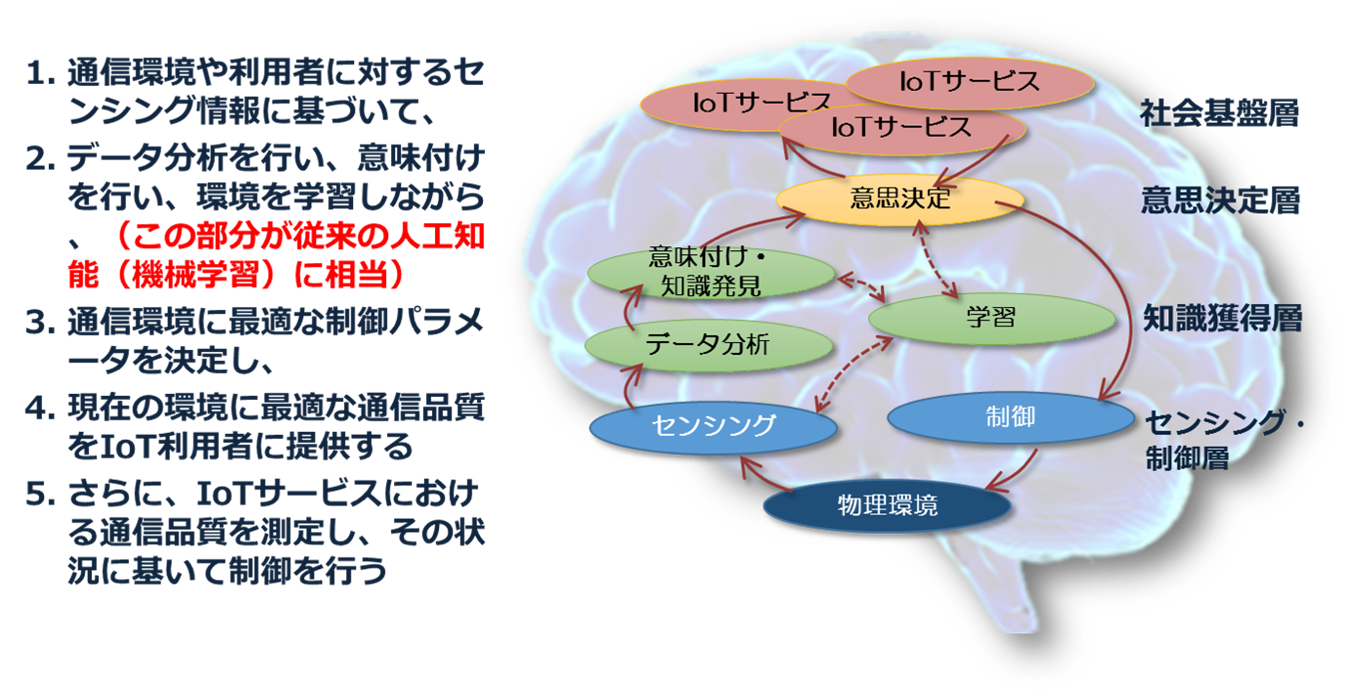

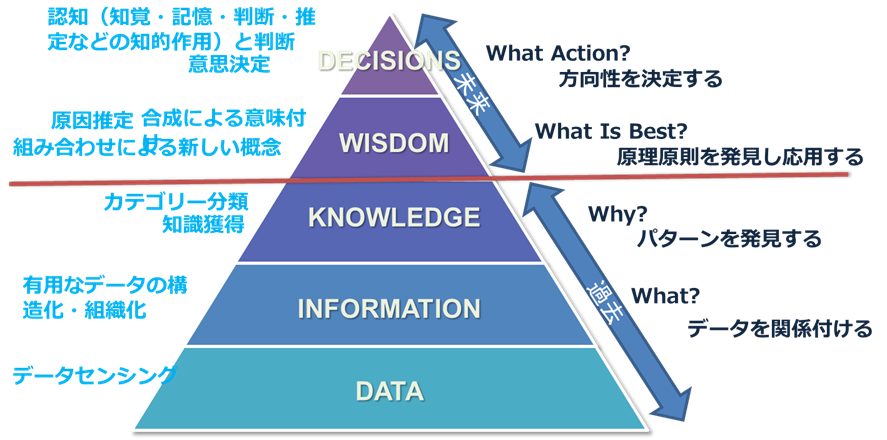

そもそも深層学習を含めたニューラルネットワークは1980年代の脳科学の知見に基づいたものであり、近年の情報技術(CPU高速化、分散化、メモリ大容量化)の発展によって可能になったものである。その結果、現在の「人工知能」は、研究者の創意工夫によって独自に「進化」してきたといっても過言ではない。より基本的な問題は、「最適性の追求」という従来の情報科学の方向性そのものが変わっていないという点である。例えば、IoTを例にとっても(図参照)、

- 応用の対象がさまざまであること

- 環境変化のあるなかで現状の状態を推定しなければならないこと

- 単に現状分析による最適解導出だけでなく制御を伴うこと

- 制御によって新たな環境に導かれること

近年、脳機能ネットワークに関する研究はfMRIなど測定装置の精密化によって飛躍的に進み、それを契機にネットワーク分析に関する研究が活発化しつつある。その結果、脳機能ネットワークは、スモールワールド性を示すこと、さらにフラクタル特性を有することが示されるようになっている。その結果、グラフ理論の観点からは、脳機能ネットワークはいわゆる「ハブノード」の故障に強いことなどが示されるようになっている。本研究グループにおいてもfMRIを用いた計測によって、脳機能ネットワークの詳細なデータを得てその分析を進めてきた。その結果、下層モジュールにおいて障害が生じても上層に波及しない性質を有すること、すなわち、外的環境に変化が生じても脳機能ネットワークの結合全体を再構築するのではなく、局所的な再構成によって対応できることなどを明らかにしてきている。現在、脳機能ネットワークのさらなる特徴抽出を行いながら、情報ネットワークへの適用を進めているところである。

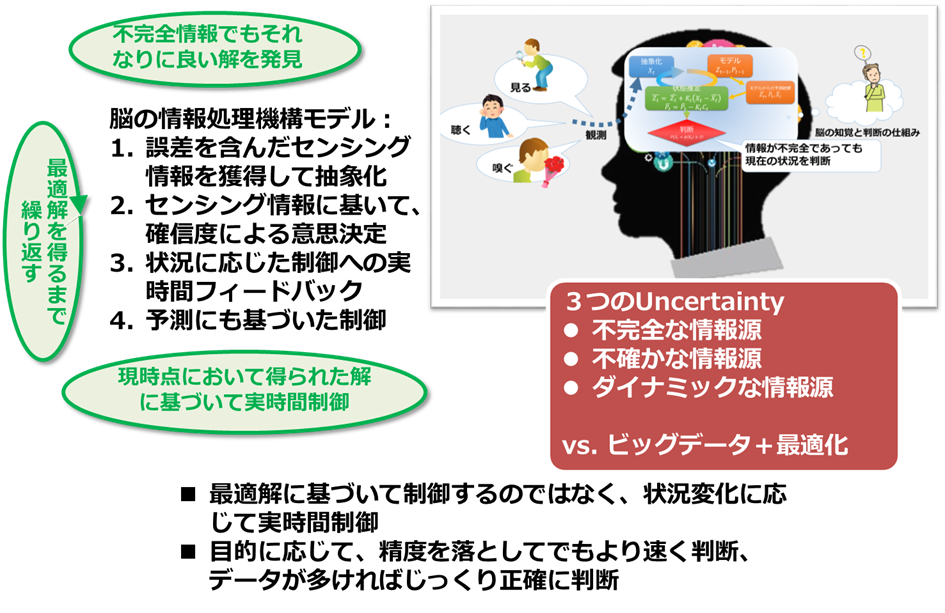

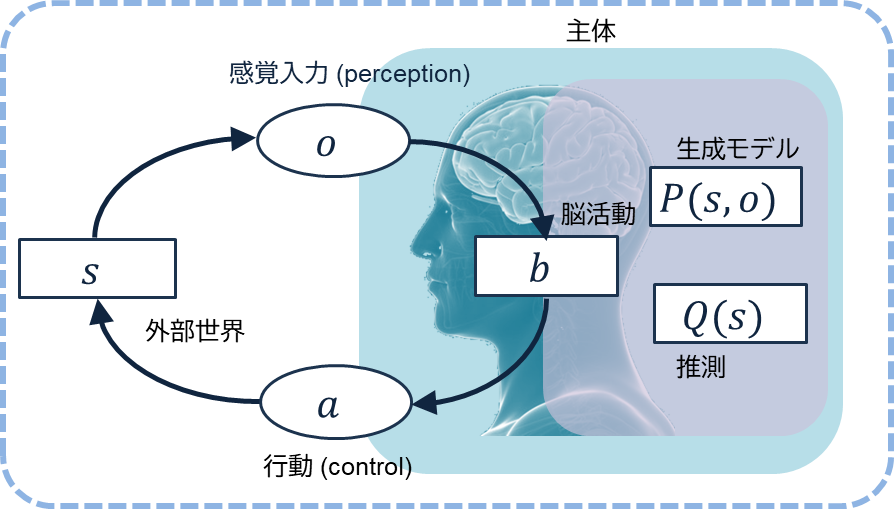

さらに、最近は脳の情報処理機構に着目し、それをネットワーク化情報処理基盤に適用する試みを行っている。既に述べたように、これまでの古典的ネットワーク設計手法においては、対象としているネットワークのトラヒック量や構成情報が1月~1年単位で取得できることが(暗黙の)仮定であり、最適化問題においてはそれらを静的情報として取り扱うこともじゅうぶん可能であった。一方、1分~1時間単位の短期的なトラヒック変動への対応は制御問題として取り扱われ、例えば経路制御によって、故障も含めた対策がとられてきた。その結果、これまでネットワーク運用現場では、物量作戦による対策がとられてきた。すなわち、トラヒック量の増大に対応するため、利用率の逼迫している箇所に順次リンクやノードの設備投資を行うという「場当たり的手法」が現実には採られてきた。インターネットにおける設計手法も数多く研究がなされてきているが、古典的ネットワーク設計手法において大前提となるトラヒック需要がそもそも予測困難であるところに根本的な問題がある。特に、仮想化技術の発展に伴い、個別の仮想化ネットワークの設定がソフトウェア制御によってごく短時間に可能になりつつある今、設計の時間粒度と制御の時間粒度はほぼ同じ時間スケールになりつつある。すなわち、空間ダイナミクスと時間ダイナミクスを同時に扱うネットワーク設計制御が必要になっている。さらに、仮想化の対象として、ネットワーク資源(リンク容量やルータ処理能力)とともに、コンピューティング資源を考慮する必要があるが、コンピューティング資源の利用率の予測は極めて困難であり、これらの指標を既知であることを前提とした既存のネットワーク設計手法は現実的ではない。一方、脳の認知を含む情報処理機構はどうか。基本的に、脳の情報処理機構は

- 誤差を含んだ知覚情報、すなわち、センシング情報を抽象化して獲得する

- 抽象化されたセンシング情報に基づいて、時間とともに変化する確信度による意思決定・行動決定を行う

- その時々の状態に応じて制御にフィードバックする

5 最新の脳科学研究に学ぶ新しい人工知能技術の創出に向けて-ゆらぎ制御からゆらぎ学習へ-

これらを踏まえて取り組んでいるのが、従来の深層学習に代わる新しい「人工知能技術」の研究開発である。一言で言うと、従来の深層学習が大量のデータ(ビッグデータ)に基づいて、大量の計算資源を用いてカテゴリー分類や予測を行うのに対して、我々の目指す人工知能技術は、少量のデータや計算資源に基づいて(スモールデータ)処理を行うものである。これらの事実は、最近の脳科学研究においても多くの示唆が得られており、それに基づいた理論的枠組みを完成させたいと考えている。

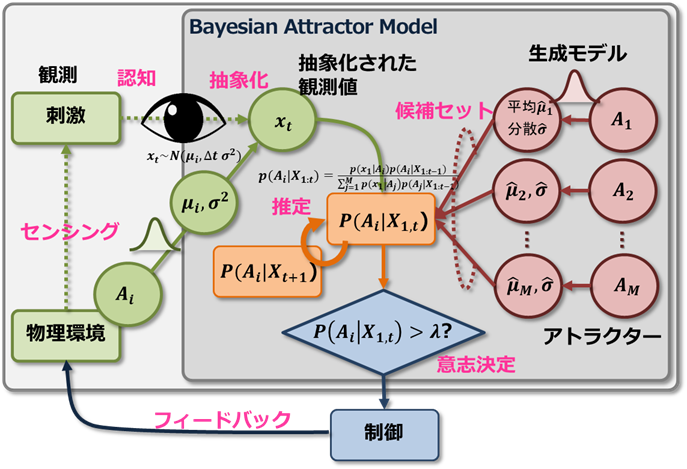

従来から我々が取り組んでいるゆらぎ制御の枠組みで捉え直すことによって、ゆらぎ学習モデルとして新たな研究開発を行っている。ベイジアンアトラクターモデルは知覚における意志決定のモデルであるが、意志決定に従った制御まで包含することによって、それが実世界にフィードバックされ、新たな環境変化に繋がり、さらにそれを知覚するというフィードバックループが産まれる。S. Bitzer, J. Bruineberg, and S. J. Kiebel, “A Bayesian Attractor Model for Perceptual Decision Making.” PLoS Comput. Biol., vol. 11, no. 8, p. e1004442, Aug. 2015.

- 誤差を含んだ知覚情報、すなわち、センシング情報を抽象化して獲得する

- 抽象化されたセンシング情報に基づいて、時間とともに変化する確信度による意思決定・行動決定を行う

- その時々の状態に応じて制御にフィードバックする

また、それだけでなく、IoTやCPSにおける実世界と仮想世界のインタラクションの有効な記述モデルになりうる。具体的には、目的に応じて、精度を落としてでもより速く意思決定をしたり、データが多ければ時間をかけてより正確に意志決定したりするといったトレードオフに基づく制御も行っている。これは「大量データを用いた学習結果に基づいて、精度の高いデータを用いて正解を探索する」深層学習とは根本的に発想の異なるものであり、仮想化情報処理基盤に真に必要とされる機能、すなわち、環境適応性の実現が可能になる。現在、人の優れた認知機能を備えたアプリケーションクライアント(ユーザエージェント)がユーザの代わりに適切にアプリケーションを動作させることによって、ユーザに対して質の高いQoEを提供するというQoE制御に取り組んでいる。さらに、人は集団のなかでその確信度を共有することができれば、意思決定における偽陰性を減少させながら真陽性を向上させる効果がすでに確認されている。この特性をMEC(Mobile Edge Computing)に適用すれば、ユーザエージェントによるユーザの認知のさらなる補正向上が期待できる。すなわち、同一MEC配下のユーザ環境において、通信環境はさほど変わらないと想定できるため、ユーザエージェントの間で確信度を交換することによって集団意思決定を行うストリーミングサービスが実現される。現在、いくつかのインタラクションシステムを対象に制御システムとして研究に取り組んでいるところである。

ただし、人の認知機能に関する研究が進展するにつれて、人の認知機能の限界もすでに明らかになっている。脳の認知機能の限界による不合理な意思決定の代表的なものに、認知バイアスがある。認知バイアスは、稀少事象の軽視(あるいは少数サンプルによる過信)や直前の経験の過度な一般化などにより起こりうるものである。最近、脳の認知機能を統一的にモデル化可能な理論的基礎として量子認知(Quantum Cognition)モデルが注目されている。量子認知モデルはメタ認知、すなわち、認知状態と意思決定の相互作用が記述可能であり、また、認知バイアス等の脳の認知機能も説明できるものである。現在、そのようなメタ認知に基づいて、意思決定を行うユーザとその正しさを評価するユーザエージェントの役割を分離し、ユーザエージェントがユーザの不適切な意思決定を検知するQoE制御にも取組んでいる。なお、これは一時もてはやされた「量子脳」とは全く別物であり、確率的な要素を含む認知を扱う包括的理論モデルである。

6 さらに脳の情報処理機構に学ぶ―認知と意思決定から能動推論まで

先述のゆらぎ学習は主として、人の認知と意思決定を中心とした情報処理モデルであり、実世界制御はアドホックに適用先の目的に沿って定めてきた。しかし、最近、認知と意思決定に加えて、行動予測まで含めて統合的に扱うモデルが注目されている。

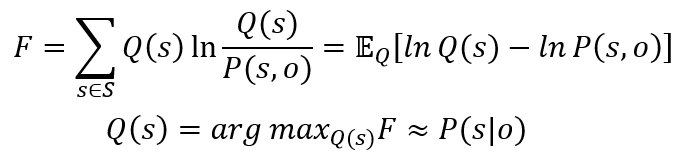

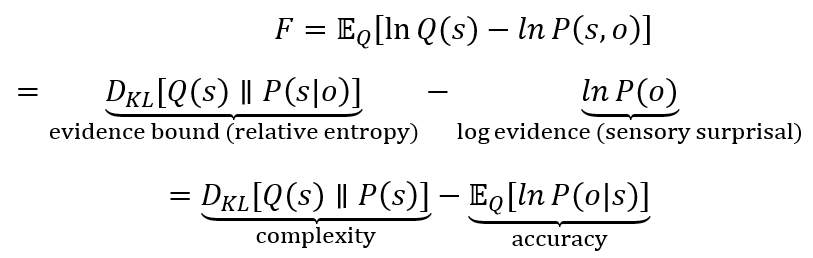

もともとはK. J. Fristonの自由エネルギー原理(“The free-energy principle: a unified brain theory?,” Nature Reviews Neuroscience, 2010)において、脳の仕組みやさらには生命体の営みを説明する統一理論として発表された。そこでは、脳が、自分で期待する状態と自分の感覚が教えてくれる状態の差として記述される。脳が感覚と一致しない外部世界の予測をした場合、すなわち、自由エネルギーのレベルが高いとき、自分の信念が感覚入力と一致するよう、誤差が最小になるように予測(推定)を修正する(変分自由エネルギー)。すなわち、変分自由エネルギーFは以下のように定義される。

現在の推測Q(s)から生成モデルP(s,o)までの距離が予測誤差の大きさであり、Fを小さくするためには、sが変化するか、Q(s)を変更するか、ということになる。さらに、自由エネルギー原理はその解釈に自由度があり、例えば、以下のように解釈することも可能である。複雑性と正確さの差として表現することにより、複雑化するシステムを対象とすれば、その制御ポリシーへの適用可能性も見えてくる。

さらに、新しい感覚入力が自分の信念と一致するように行動するポリシーを探索する場合は能動推論と呼ばれ、行動の結果を予測する。また、信念や知覚の変化だけでなく、行動の背後にある動機も説明可能になる(期待自由エネルギー)。通常、行動ポリシーは既知、あるいはランダムなどが選ばれるが、生成モデルからその尤度を評価することによって、次ステップの行動を決定することが可能になる。探索を効率的に行いたい場合、行動ポリシー(𝝅)を適切に定義することが重要であるが、この点についてはわれわれが取り組んできたゆらぎ制御やゆらぎ学習におけるアトラクタの定義や追加・削除手法が有効になると考えている。

なお、自由エネルギー原理は認知だけでなく、感情や思考、さらに他人の思考推定などに拡張される一方、批判も続いている。例えば、文献“Free-Energy Principle, Computationalism and Realism: a Tragedy, 2020”では「自由エネルギー原理は概念として支離滅裂であり、道具として解釈することが安全である」との指摘があり、さらに、文献“Why I’m not into the Free Energy Principle, 2023”でも「細菌と人の脳の両方に同じ理論が適用できるという主張が正しいとすれば、それは人の脳が理解できるはずがないことを意味する」という主張もある。一方で、他分野との関係をみると、システム制御分野における“CAI: Control as Inference”や機械学習分野における強化学習などと、考え方そのものに強い類似性がある。また、用いる計算手法もKL Divergenceによる分布推定、MCMCの利用等多くの共通点がある。CAIや強化学習は、行動をとった後の報酬がわかることを前提としたものであるが、例えば、Deepak PathakのCuriosity-driven Machine Learningは外部報酬(extrinsic reward)に依存せず、予測誤差の最小化をエージェント報酬とするものであり、それぞれ独立に発展してきたものであるが、最近「能動推論」として収束しつつある観がある。我々は、能動推論は、知覚、学習、意思決定、行動を1つのモデルアーキテクチャに統合した上で、実世界やセンシング情報における不確実性を取り扱えること、時間変動を明示的に取り扱えることなどから、次に述べる確率的デジタルツインの展開に適用している。

7 確率的表現を用いた時空間統合デジタルプラットフォーム(確率的デジタルツイン)の構築

さらに、先述のデジタルツインを対象とした時空間を統合する仮想世界(デジタルクラウド)に関する研究を開始した。これまでもさまざまな学術分野で実世界と仮想世界の融合が言われてきたが、実際に産業応用するために本質的に欠けているものがある。それは、実世界と仮想世界の双方向の実時間インタラクションである。実世界と仮想世界の融合とはすなわち、実世界の変化を仮想世界に反映させるだけでなく、仮想世界における行動決定が実世界に物理的な影響を及ぼすということであり、このインタラクションは安全確実であることが至上命題である。しかし、実世界は常に変化し、オブジェクトは常に外的環境の変化の影響を受ける。例えば、ロボットの遠隔操作の場合、まず現在のロボットの外的環境をさまざまなセンサにより認識し環境分析を行った後、操作者が次のロボットの行動を決定し、ロボットに伝えることによって制御を行う。その結果、ロボット移動により外的環境が変化する。そのため、できるだけ小さい時間粒度で制御を行いたいが、短時間の認識処理では誤差が大きくなってしまうというトレードオフが存在する。今後どのように通信やコンピュータが高速化しても、瞬時に確実に実世界を理解することは実質困難であり、まったく誤差のないリアルタイムのインタラクションは現実には困難である。

このような問題を解決し、実世界と仮想世界をリアルタイムに融合するデジタルプラットフォームを構築するために、インタラクション処理を効率的に行っている人の脳に学ぶ。視覚を含めたさまざまな感覚器官から情報をセンシングしながら、脳は統合処理によって外界を広く認識し、脳内にそのイメージを構築し、それに基づいてリアルタイムに意思決定/行動決定することによって実世界とのインタラクションを行っている。特に、実世界と仮想世界の相互のインタラクションを必要とする新しいサービスを創出するためのデジタルプラットフォームを実現することが肝要である。そのために、実世界と仮想世界の間に横たわる不確実性の壁を克服し、リアルタイムなインタラクションを実現する。もちろん、瞬時に確実に実世界を理解することは依然として困難である。そこで発想を転換し、システム全体としては認識誤差や制御誤差の存在を前提としたうえで、ロバストに認識/判断/学習/行動するように設計することが合理的である。つまり、実世界と仮想世界を確定的ではなく確率的に結びつけることが目的である。すなわち、実世界を確率的に表現する時空間統合仮想世界(デジタルクラウド)を実現し、ゆらぎ学習による実世界学習・認知・意思決定を行い、実世界へフィードバックする。実世界制御として近年注目されている確率的システム制御を対象とする場合にはその親和性は大きく、これによって全体像が完成する。

センサの数や精度、情報処理や通信リソースの限界から、現状のデジタルツインは現実世界を完全にコピーすることはできていない。またデジタルツインの主な用途として対象の未来の状態の予測があるが、現実世界のコピー(モデル)が不確かである以上、その予測も不確かさを含むことは避けられない。そのような不確かさが存在することを確率事象として積極的に表現する「確率的時空間デジタルツイン」を実現することで、仮想空間と現実空間の差異を現状分析や未来予測で正しく扱うことを可能にし、分析や予測の精度を向上させる。また仮想空間と現実空間の差異を確率として定量的に認識することで、限られたリソースを有効活用して、差異を解消可能とする。特に、対象の未来状態の予測精度の向上にあたっては、その不確実性を小さくすることが重要である。有限なネットワーク資源や計算資源の制約がある中で、対象あるいはその周辺環境のどんな状態をデジタル化することが予測精度向上に効果的であるか、をモデル化し、予測精度向上に寄与するデータを優先して収集することで、予測精度の向上を可能とする。さらに、周辺環境の不確実性に加え、ロボット自身が持つ不確実性(機械的な遊び、動きのブレ、センサノイズ、制御遅延など)による状態変化にロバストに適応するようにロボットを制御するため、ロボット自身が持つ不確実性(機械的な遊び、動きのブレ、センサノイズ、制御遅延など)と周辺環境の将来変化の2つが安全性に与える影響をリスクとして評価し、そのリスクを最小化する制御を決定・実施することで安全を確保しつつ、作業効率を最大化することを狙う。

そのためには、完全で誤りのない世界表現を追求するのではなく、確率的な世界表現(確率的デジタルツイン)によって初めて安心安全な社会の実現が可能になると考えている。これは逆説的ではあるが、安心安全なサービスを実現するためには、実世界に存在する不確かさや、それを観測する際の不確定性を定量的に把握し、どこまで安全性が担保できるかをそれぞれのサービスごとに見極めることが重要である。それがあって初めて、リスク分析を行い、サービス実現が可能になる。例えば、ロボット制御は時間制約の厳しいものであり、その実用性を確認することによって、AR(仮想現実)や、スマートシティ、自動運転のための高精度なダイナミックマップなど、他のサービスにも応用可能なものであることが示されようになる。肝要な点は、それぞれのサービスにおいて、必要とされる制御時間粒度が異なるものであり、また、サービスに必要とされる信頼性も異なっている。デジタルツインによる仮想世界表現において、それぞれの確率的な確からしさが与えられれば、それに基づいてリスク管理も併せたサービスが実現できるようになる。